概念:

商业哲学家 Jim Rohn 说过一句话,“你,就是你最常接触的五个人的平均。”那么,在分析一个人时,我们不妨观察和他最亲密的几个人。同理的,在判定一个未知事物时,可以观察离它最近的几个样本,这就是KNN(k-邻近)算法。

K-近邻算法是一种基本分类和回归方法。

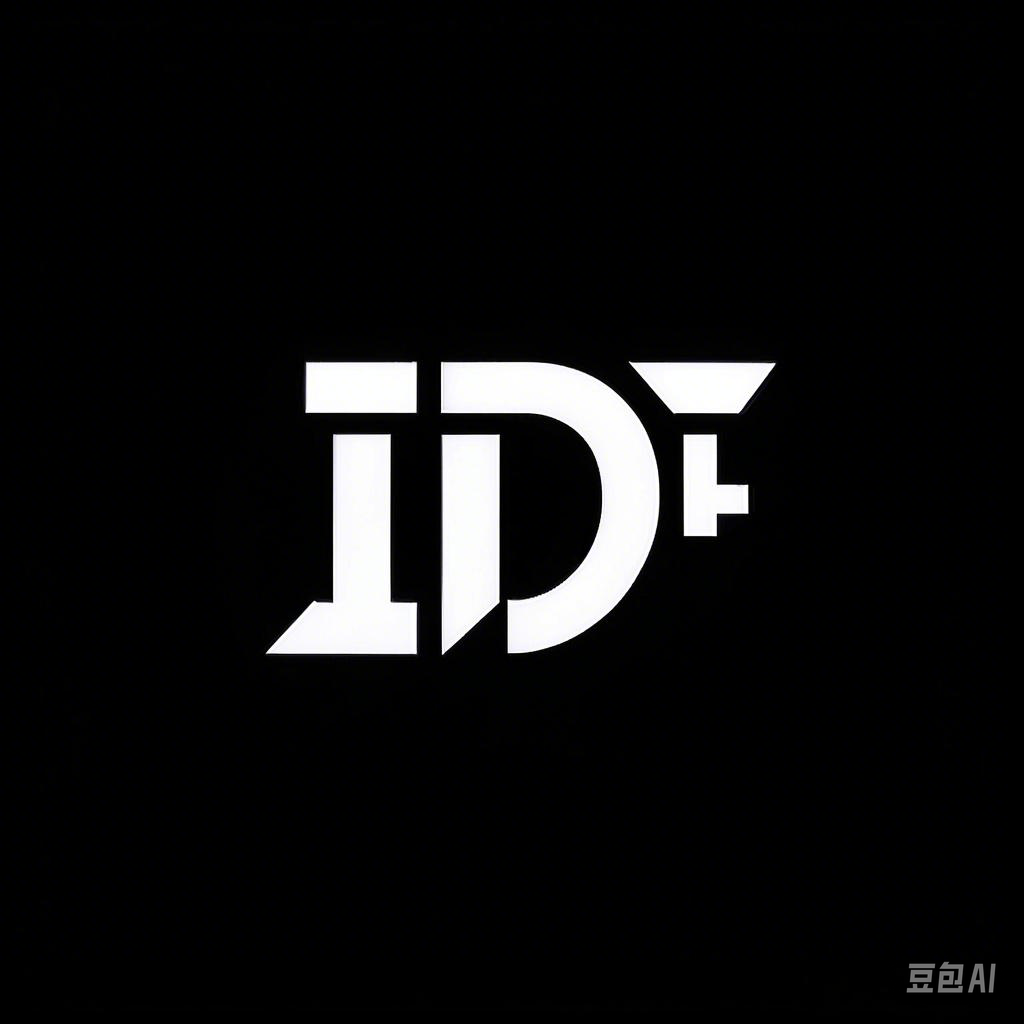

K-近邻算法,即是给定一个训练数据集,输入一个新的实例,在训练数据集中找到与该实例最邻近的K个实例,这K个实例主要是哪一类别,那么就把该实例分类到这个类中。引用维基百科上的一幅图:

蓝色方块与红色三角形为训练集中的实例,绿色小圆是新输入的实例,现在在现有实例中取K个离小绿圆最近实例用于判断其类别。

- 当K=3时,所取实例在实线圆内,红三角占比最大,将新输入实例归为红三角一类。

- 当K=5时,所取实例在虚线圆内,蓝方块占比最大,将新输入实例归为蓝方块一类。

在KNN中存在两个重要问题,一个是K的取值问题,一个是距离计算问题,这里先不做讨论,仅仅引入KNN这个概念,明白它是一个什么东西,在后面文章中我们再对这两个问题进行深入讨论。下文将通过sklearn包来实现KNN。

具体实现:

(一)环境:

语言环境:Python 3.10

编 译 器: PyCharm

**(二)具体步骤:

1.问题背景:

背景: 海伦一直使用在线约会网站寻找适合自己的约会对象。尽管约会网站会推荐不同的人选,但她没有从中找到喜欢的人。经过一番总结,她发现曾交往过三种类型的人:

- 不喜欢的人;

- 魅力一般的人;

- 极具魅力的人。

她现在总结好的数据中(即训练集)包含三种特征: - 每年获得的飞行常客里程数

- 玩视频游戏所耗时间百分比

- 每周消费的冰淇淋公升数

她希望根据现有的数据来判断一个陌生男人会被她归到哪一类。

- 导入数据:

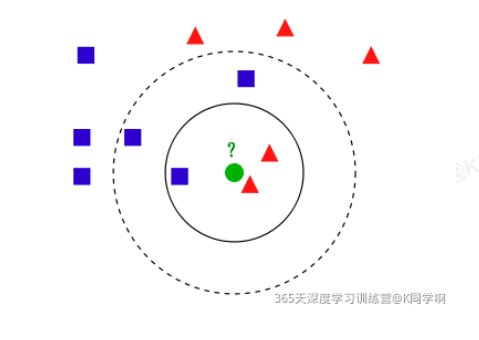

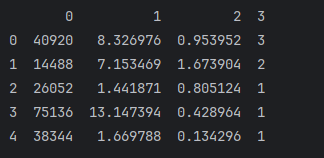

*数据集:类似下面,可以自己造一个

数据标签解释:

- 0:每年获得的飞行常客里程数

- 1:玩视频游戏所耗时间百分比

- 2:每周消费的冰淇淋公升数

- 3:人物类别(不喜欢的人、魅力一般的人、极具魅力的人)

import pandas as pd

data = pd.read_table('./datingTestSet2.txt',

sep='\t',

header=None)

print(data.head()) # 打印数据的默认前5行

X = data.iloc[:, :3]

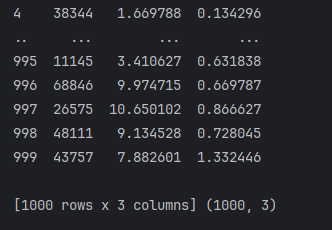

print(X, X.shape)

y = data.iloc[:, 3]

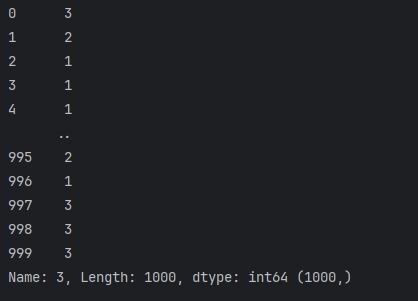

print(y, y.shape)

3. ** 切分训练集与测试集**:

from sklearn.model_selection import train_test_split

X_train, X_test, y_train, y_test = train_test_split(X,

y,

test_size=0.25,

random_state=3)

- KNN算法模型:

from sklearn.neighbors import KNeighborsClassifier

knc = KNeighborsClassifier()

knc.fit(X_train, y_train)

- 结果预测:

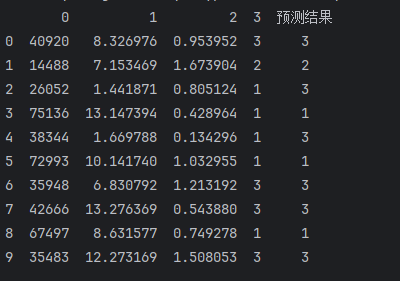

data["预测结果"] = knc.predict(data.iloc[:, :3])

print(data.head(10))

6. 模型评分:

# 模型评分

scoreK = knc.score(X_test, y_test)

print("模型评分:", scoreK)